[本站讯]近日,软件学院多媒体挖掘推理与生成(MMRC)实验室两项研究成果被人工智能领域顶级会议NeurIPS 2025录用,山东大学均为第一作者和通讯作者单位。

成果一:Class-wise Balancing Data Replay for Federated Class-Incremental Learning

联邦类别增量学习(FCIL)的目标是跨多个客户端协同处理不断增加的新任务。在各种方法中,数据回放已成为一种颇具前景的解决方案,它能够通过重新引入先前任务中的代表性样本来缓解遗忘问题。然而,其性能通常受限于类别不平衡,这种不平衡既存在于回放缓冲区内部(由于全局感知有限),也存在于已回放类别与新到达类别之间。

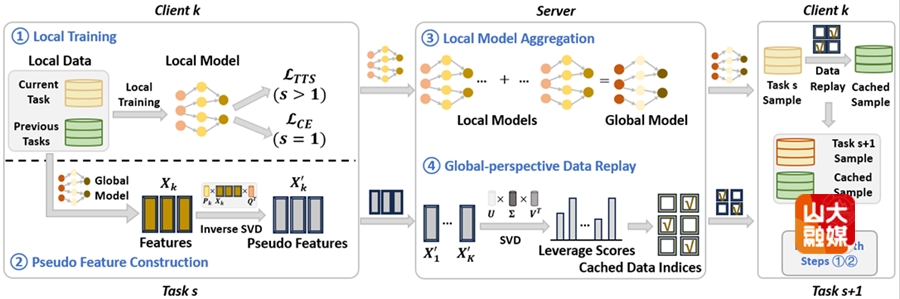

为了解决这一问题,本文提出了一种面向 FCIL 的类别均衡数据回放方法(FedCBDR)。该方法引入全局信号来调控类别均衡的记忆构建,旨在实现分布感知的回放,并缓解非独立同分布(non-IID)客户端数据带来的挑战。FedCBDR包含两个核心模块:其中,全局视角数据回放模块通过特征空间分解重建隐私保护的先前任务全局伪表示,从而在保留关键属性信息的同时,实现跨客户端的知识整合,并引入一种基于重要性的选择机制,在全局数据分布感知的引导下实现类别均衡回放;另一方面,任务感知温度缩放模块提出了一种多层次的动态置信度校准策略,将任务级温度调整与实例级加权相结合,通过调节softmax分布的锐度来平衡多数类与少数类之间的预测置信度,从而增强模型在历史任务样本与当前任务样本之间类别不平衡情况下的鲁棒性。实验结果验证了FedCBDR在异质数据分布下能够实现类别均衡的采样,并在早期任务与近期任务之间存在不均衡时提升泛化性能,相比六种最新方法在 Top-1 准确率上带来 2%–15% 的提升。

本文第一作者为软件学院博士研究生齐壮,通讯作者为软件学院教授孟雷。

成果二:Global Prompt Refinement with Non-Interfering Attention Masking for One-Shot Federated Learning

联邦提示学习(FPL)通过在冻结的预训练模型上微调轻量化提示,从而实现高效的通信自适应。然而,现有的 FPL 方法通常依赖于全局信息,而这类信息仅在第二轮训练之后才能获得,用于促进客户端模型之间的协作。因此,这些方法本质上依赖多轮通信才能充分发挥其优势。此外,现有的一次性联邦学习方法大多专注于拟合已见任务,却缺乏跨任务的泛化能力。

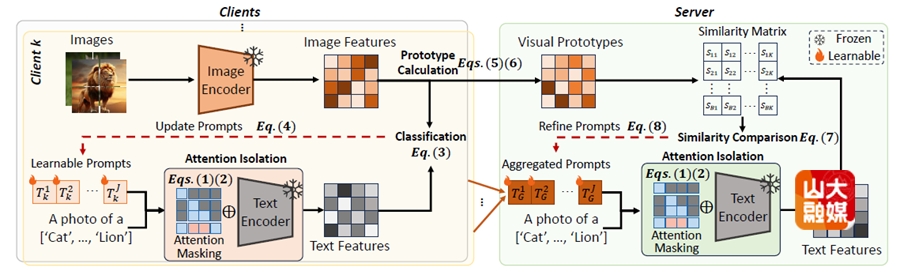

为弥补这一不足,本文提出了全局提示优化与非干扰注意力掩码(GPR-NIAM)方法。该方法通过一种掩码机制避免对原始标记嵌入的修改,从而在跨任务间保留可迁移的知识。可学习提示嵌入与原始文本标记嵌入之间的交互是单向的,这保证了后者保持不变。具体而言,GPR-NIAM包含两个主要模块。首先,注意力隔离模块通过一种新的掩码策略选择性地调控提示信息的流动。它抑制可学习提示标记在所有编码层中对原始文本标记的注意力,从而有效防止对文本输入标记嵌入的改变;此外,它还对反向注意力进行重加权,以鼓励模型更有效地从原始文本中提取与任务相关的特征。其次,跨孤岛协作优化(CSCR)模块利用来自多个客户端的视觉表征,并结合多源视觉监督,以集中方式优化全局提示,从而进一步缓解数据异质性带来的负面影响。大量在十个基准数据集上的实验表明,GPR-NIAM 在类别层面和领域层面的泛化性能上均优于八种最新方法。

本文第一作者为软件学院博士研究生齐壮,通讯作者为孟雷教授。

神经信息处理系统大会(Conference on Neural Information Processing Systems,NeurIPS)是机器学习与人工智能领域最具影响力的国际顶级学术会议之一(CCF A类),长期聚焦于机器学习、深度学习、计算机视觉、自然语言处理、优化方法、神经科学等前沿研究方向。本次会议共收到21575篇有效投稿,录用率约24.52%,其中4525篇为Poster、688篇为Spotlight、77 篇为Oral。实验室本次被收录的两项成果聚焦联邦持续学习与联邦提示学习等前沿议题,其中联邦持续学习研究入选大会Oral(77/5290,Top-1.5%)。